Nel primo articolo vi ho guidato nel pianificare e lanciare il vostro primo lift test. Quella era la parte facile. Adesso inizia il lavoro difficile: dare un senso ai risultati.

I dati non parlano da soli e un report di un test non è un semplice "promosso" o "bocciato". È un pezzo di un puzzle complesso. Il vostro compito non è solo leggere un numero, ma capire la storia che racconta per prendere decisioni che impattano il budget.

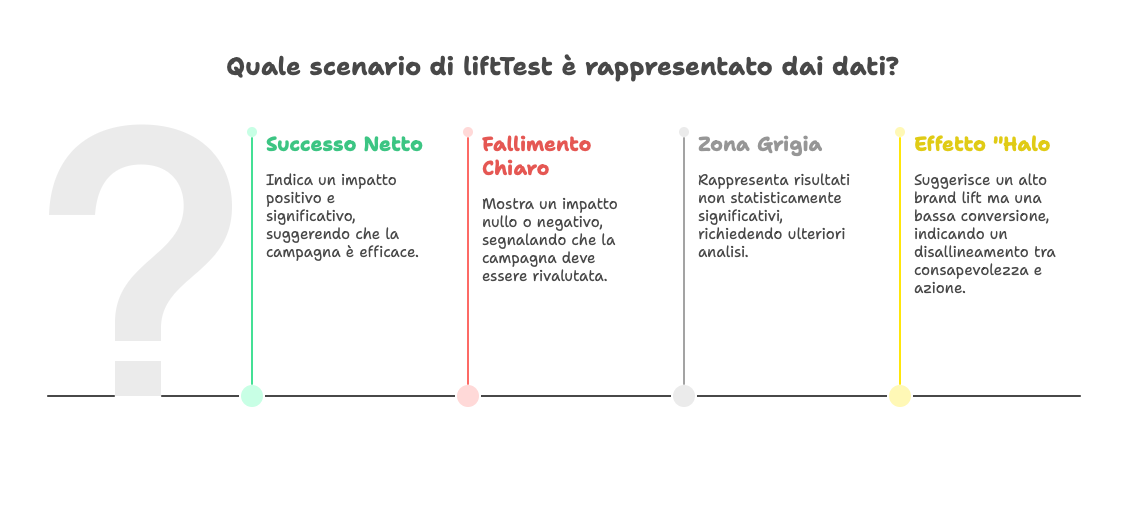

Questa guida è un decodificatore per i quattro scenari più comuni, più uno bonus che molti ignorano. Vi mostrerò come trasformare ogni risultato, anche il peggiore, in un'azione intelligente.

Scenario A: Il Successo Netto (Lift Positivo e Significativo)

Cosa significa: I dati sono chiari. La campagna ha causato un aumento delle conversioni o delle metriche di brand. L'investimento ha prodotto valore incrementale.

La trappola: Aumentare il budget del 100% e sperare in un raddoppio dei risultati. Non funzionerà.

Framework d'Azione:

Scalare in Modo Controllato: Aumentate il budget della campagna del 20-30%, non di più. Lanciate una nuova misurazione e monitorate una metrica chiave: il Costo per Acquisizione Incrementale (iCPA). Se questo valore inizia a salire rapidamente, avete raggiunto il punto di saturazione e un ulteriore aumento di spesa sarebbe inefficiente.

Sezionare il Successo: I risultati positivi nascondono ottimizzazioni. Ponetevi domande precise e cercate le risposte nei report della piattaforma (se disponibili):

Quale specifica creatività ha generato più lift?

Quale segmento di pubblico ha risposto meglio?

Ci sono state differenze di performance tra posizionamenti (es. Stories vs. Feed)? Usate queste risposte per riallocare il budget all'interno della campagna, massimizzando l'efficienza.

Standardizzare la Tattica: Se il test era su una nuova strategia, il risultato la valida. Sistematizzatela e integratela nel vostro marketing mix di base.

Scenario B: Il Fallimento Chiaro (Lift Nullo o Negativo)

Cosa significa: La campagna non ha aggiunto valore. Nel peggiore dei casi (lift negativo), ha cannibalizzato altri canali. Avete sprecato soldi.

La trappola: Incolpare il team o l'agenzia.

Framework d'Azione:

Festeggiare la Scoperta: Avete appena dimostrato con dati certi che un'attività non funziona. Avete fermato uno spreco di budget. Questa è una vittoria per l'intelligenza aziendale, non un fallimento del team.

Tagliare la Spesa. Subito: Interrompete la campagna o riallocate il budget immediatamente. Ogni giorno di attesa è un costo.

Eseguire un'Analisi Post-Mortem (Checklist): Usate questo schema per capire il "perché" del fallimento:

L'Audience era Sbagliata? (Es. Stavamo parlando a clienti esistenti che avrebbero comprato comunque?).

La Creatività era Debole? (Es. Il messaggio non era chiaro o rilevante?).

L'Offerta era Inadeguata? (Es. Il prodotto/prezzo non era competitivo in quel momento?).

Il Canale era Inappropriato? (Es. Stiamo cercando di vendere un prodotto complesso con un annuncio su TikTok?). Questa analisi è cruciale per non ripetere l'errore.

Riallocare il Budget Risparmiato: Spostate le risorse su canali con lift incrementale provato o usatele per finanziare il prossimo test su un'ipotesi più solida.

Scenario C: La Zona Grigia (Risultato Non Statisticamente Significativo)

Cosa significa: È il risultato più comune. Vedete una piccola differenza tra i gruppi, ma il test vi dice che potrebbe essere puro caso. Il risultato è inconcludente.

La trappola: Dire "beh, è quasi positivo, continuiamo". No. Significa "non lo so".

Framework d'Azione:

Valutare la Potenza del Test: Chiedetevi se il test era abbastanza "potente" da rilevare un effetto. La potenza statistica è come la magnificazione di un microscopio: se è troppo bassa (a causa di budget o durata insufficienti), non riuscirete a vedere un effetto piccolo anche se esiste. Rivedete la checklist di fattibilità del primo articolo.

Applicare la Regola di Default: In assenza di un segnale chiaro, la decisione più sicura è considerare l'ipotesi "non provata". Non aumentate l'investimento. L'onere della prova era a carico della campagna, e ha fallito nel fornirla.

Rilanciare il Test su Larga Scala: Se l'ipotesi è strategica, l'unica via d'uscita è ripetere il test con più "potenza": budget più alto, durata maggiore, audience più ampia. Questo vi costringerà a ottenere un risultato definitivo, positivo o negativo che sia.

Scenario D: L'Effetto "Halo" (Brand Lift Alto, Conversion Lift Basso)

Cosa significa: Una campagna video ha aumentato la notorietà del brand, ma non ha generato vendite immediate.

La trappola: Valutarla con le stesse metriche di una campagna Google Search e bollarla come un fallimento.

Framework d'Azione:

Confrontare con l'Obiettivo Primario: Se lo scopo era il branding, il test è un successo. State misurando l'efficacia rispetto all'obiettivo corretto.

Quantificare l'Impatto a Lungo Termine: Questo è difficile, ma necessario. Ecco come iniziare a misurare l'impatto indiretto:

Analisi di Coorte: Tracciate il gruppo Test nel tempo. Mostra tassi di conversione più alti o un valore medio più alto nei 30-90 giorni successivi, anche su altri canali?

Misurare il Search Lift: Il Brand Lift ha generato un aumento dimostrabile delle ricerche organiche per il vostro brand? Questo è un effetto a cascata diretto e misurabile.

Usare Strumenti Avanzati: Questo tipo di impatto è il dominio dei Marketing Mix Model (MMM). Se il branding è al centro della vostra strategia, questi risultati sono la giustificazione perfetta per investire in un MMM che possa quantificare il valore a lungo termine del brand.

Scenario E (Bonus): Il Test Invalido o "Sporco"

Cosa significa: Qualcosa è andato storto a livello tecnico. I dati sono inaffidabili.

Come individuarlo: Picchi di dati totalmente anomali; tassi di conversione del gruppo di controllo irrealistici (es. 20% quando la media è 1%); errori segnalati dalla piattaforma.

Framework d'Azione:

NON Interpretare i Dati: La prima regola è non fidarsi. Qualsiasi conclusione sarebbe basata su spazzatura.

Indagare la Causa Tecnica: Lavorate con i team tecnici o i partner per un'analisi forense. Il problema era un pixel di tracciamento? Una configurazione errata dell'audience di controllo?

Invalidare e Ripianificare: L'unica azione è dichiarare il test nullo, risolvere il problema tecnico alla radice e pianificare un nuovo test da zero.

Nel Prossimo Articolo: Budgeting per la Verità

Ora che sappiamo come interpretare i risultati, sorge una domanda cruciale: come finanziamo questa ricerca della verità? Nel prossimo articolo, parlerò di soldi: come strutturare il budget per il vostro ecosistema di misurazione, allocando le risorse in modo strategico tra Attribuzione, Lift Test e altri strumenti per massimizzare l'intelligenza di marketing.

Conclusione: Il Costo della Non-Interpretazione

Interpretare i risultati di un lift test non è un esercizio accademico. È una disciplina con un impatto diretto sul conto economico. Sbagliare l'interpretazione ha un costo:

Interpretare male un successo costa crescita mancata o budget bruciato oltre il punto di saturazione.

Interpretare male un fallimento costa la perpetuazione dello spreco su attività inutili.

Interpretare male la zona grigia costa immobilità strategica, paralizzati dall'incertezza.

Interpretare male l'effetto halo costa la distruzione di asset a lungo termine, uccidendo campagne di branding vitali.

Ogni risultato, se letto correttamente, è un'indicazione chiara su dove allocare il prossimo euro.

Link Utili di questa settimana:

Demystified MMM: Una guida essenziale per CMO e CFO

Il valore dell’incrementalità: dal dubbio alla prova il marketing che genera valore reale

James & James Is Using MMM To Keep Its AI-Based Ad Buying ‘Honest’

Share this post